思爱普

mybatis

windows

最近点对问题

PWM

html5期末大作业

Linux基础指令

系统错误

系统架构

火鹰优化算法

html静态页面

视频

飞机大战

宠物

Java中的打印流

CSS选择器

西枢纽

Advisories

洛谷

PC网站H5微信登录

vllm

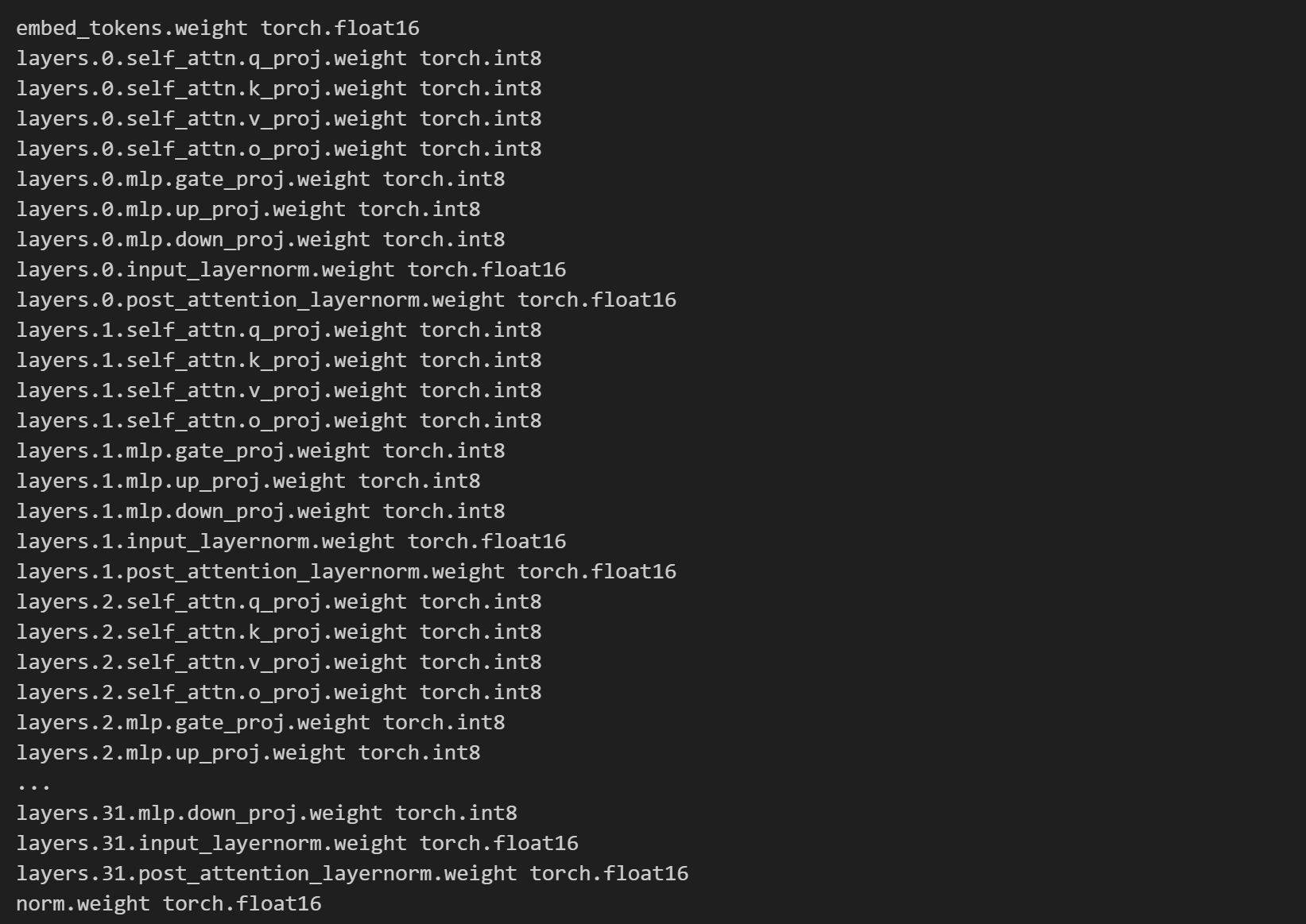

2024/9/13 8:12:34【LLM】vLLM部署与int8量化

Acceleration & Quantization vLLM

vLLM是一个开源的大型语言模型(LLM)推理和服务库,它通过一个名为PagedAttention的新型注意力算法来解决传统LLM在生产环境中部署时所遇到的高内存消耗和计算成本的挑战。PagedAttention算法能有效管理…

vllm 推理qwen gguf模型使用案例;openai接口调用、requests调用

参考: https://docs.vllm.ai/en/latest/getting_started/examples/gguf_inference.html https://docs.vllm.ai/en/latest/models/engine_args.html

安装:升级到0.5.5才行

pip install -U vllm -i https://pypi.tuna.tsinghua.edu.cn/simple -trusted-host pypi<

《深入浅出多模态》(九)多模态经典模型:MiniGPT-v2、MiniGPT5

🎉AI学习星球推荐: GoAI的学习社区 知识星球是一个致力于提供《机器学习 | 深度学习 | CV | NLP | 大模型 | 多模态 | AIGC 》各个最新AI方向综述、论文等成体系的学习资料,配有全面而有深度的专栏内容,包括不限于 前沿论文解读、资料共享、行业最新动态以、实践教程、求职…

Failed to import from vllm._C with ImportError问题解决

文章目录 1.问题描述2.问题解决 1.问题描述

笔者在使用FastChat框架中的vllm_work部署DeepSeek-Coder-V2时遇到了如下报错:

$ python3 /ssdwork/FastChat/fastchat/serve/vllm_worker.py --model-path /ssdwork/DeepSeek-Coder-V2-Instruct/ --num-gpus 8

WARNING…

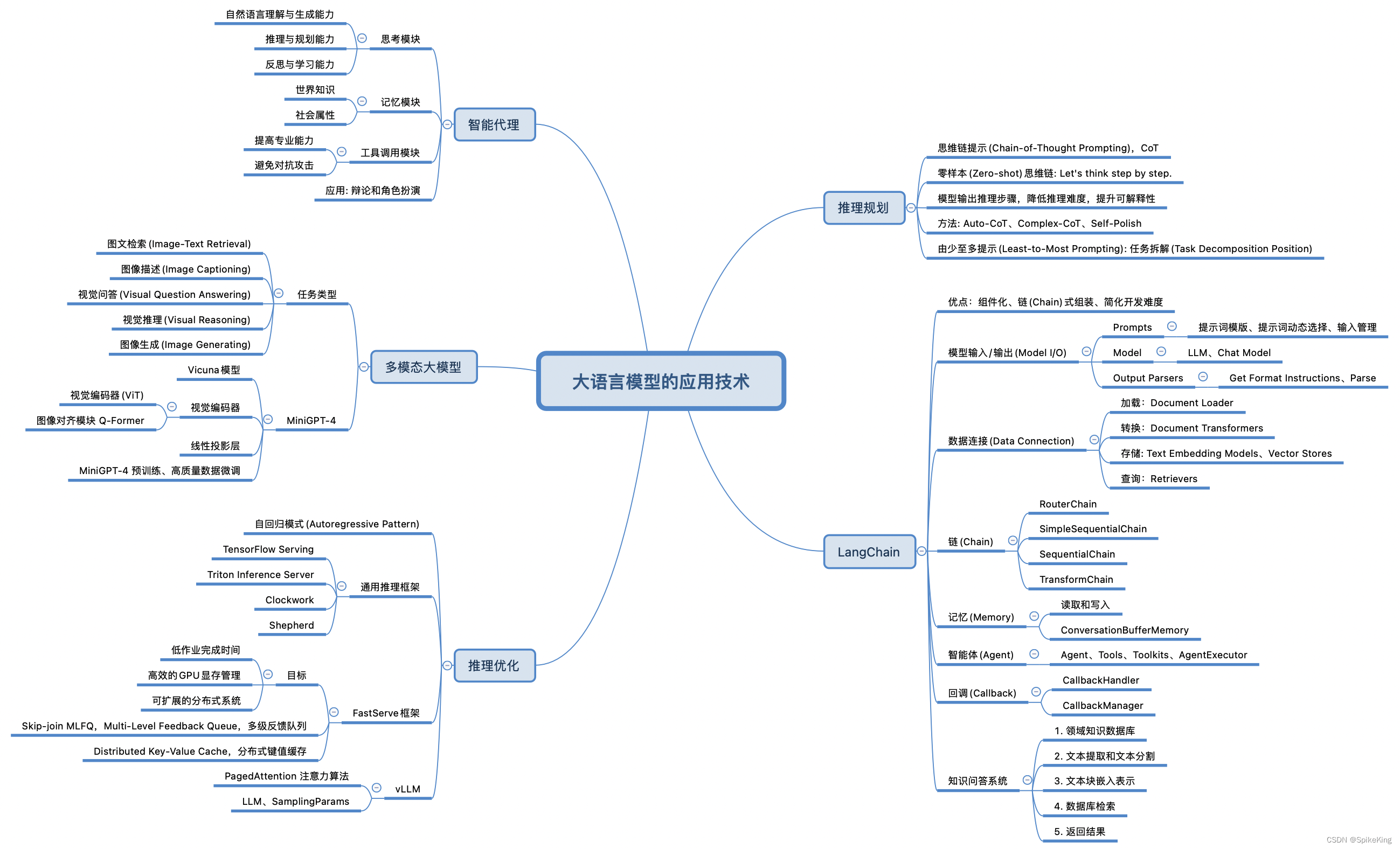

LLM - 大语言模型(LLM) 的 应用技术

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://blog.csdn.net/caroline_wendy/article/details/137503579 大语言模型(LLM) 的应用技术范围非常广泛,即: LangChain:开发框架,专为大型语言模型设计,以提高开发人工智能应用的效率,允许开发者将语言模…

Head size 160 is not supported by PagedAttention.

Supported head sizes are: [64, 80, 96, 112, 128, 256]. 错误信息:

Head size 160 is not supported by PagedAttention. Supported head sizes are: [64, 80, 96, 112, 128, 256].解决方法:

vim /root/miniconda3/envs/myvllm/lib/python3.10/site-…

大模型推理加速框架vllm部署的实战方案

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法…

vLLM vs TGI 部署大模型以及注意点

LLM 高并发部署是个难题,具备高吞吐量的服务,能够让用户有更好的体验(比如模型生成文字速度提升,用户排队时间缩短)。

vllm github 仓库

1 vLLM

1.1 启动模型服务

# cd /workspace/vllm

python3 -m vllm.entrypoin…

解决离线运行vLLM 启动报dns.google错

现象

vLLM版本0.3.3离线运行时,报类似下面形式的错误:

File "/usr/local/lib/python3.10/dist-packages/vllm/entrypoints/llm.py", line 109, in init self.llm_engine LLMEngine.from_engine_args(engine_args) File "/usr/local/li…